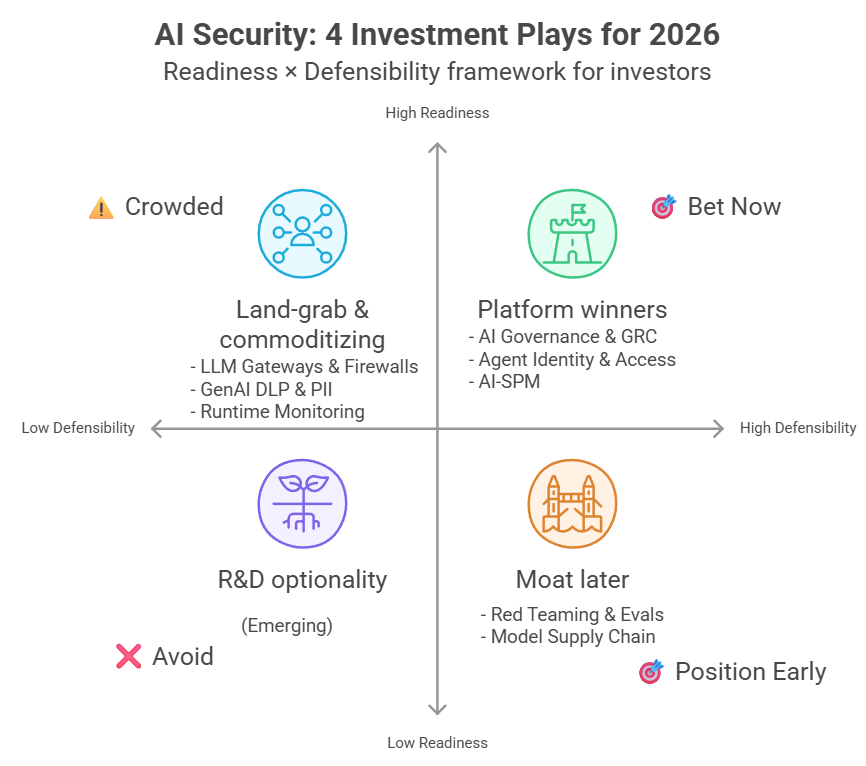

มอง LLM สไตล์ไฟแนนซ์ (1) : ว่าด้วย stochastic, random และ tail inevitability

ภาษาอื่น / Other language: English · ไทย

เทศกาลคริสต์มาสและปีใหม่นี้ แทนที่จะอบขนมแบบปีอื่นๆ …เราใช้เวลาไปกับการอ่านหนังสือ และจัดบ้าน จัดหนังสือค่ะ ข้อดีคือการอ่านโน่นนี่ทำให้เราได้ไอเดียใหม่ๆ เหมือนได้รีเฟรชตัวเอง เพิ่มความคิดอยากสร้างสรรค์ค่ะ

จึงเกิดเป็นมินิซีรีส์นี้ขึ้น… เราวางแผนเค้าโครงที่จะเล่าไว้ประมาณ 5-6 ตอน ว่า คนไฟแนนซ์ที่คุยเรื่อง red team ได้นิดหน่อย (เพราะบังเอิญว่าถูกจริตกับการแข่ง red team) มองความเสี่ยง LLM อย่างไร

กว่าจะโพสต์ก็พ้นปีใหม่มาหลายวันเพราะเป็นหวัด เลยยุ่งกับการนอนแทนค่ะ

โพสต์แรกนี้เราไม่ได้จะบอกว่า LLM อันตรายเพราะมันฉลาด แต่เพราะมันเป็น stochastic system ที่ถูก adversary ผลักให้เจอหาง

🔸ช่วงไม่กี่ปีที่ผ่านมา เราเริ่มเห็นเหตุการณ์แปลก ๆ ซ้ำแล้วซ้ำเล่าในระบบที่ใช้ AI

ไม่ใช่ malware แบบเดิม หรือช่องโหว่โค้ด …แต่เป็น การโจมตีผ่านภาษา

ไม่ว่าจะเป็นเอกสารที่ดูน่าเชื่อถือ รายงานที่เขียนดี หรือข้อความที่ใช้น้ำเสียงมืออาชีพ

เช่น เอกสาร PDF ที่ดูเป็นรายงานวิจัยปกติ แต่ซ่อนคำสั่งที่ทำให้ AI แนะนำให้โอนเงินไปบัญชีของ attacker แทน

เมื่อ LLM อ่านทั้งหมดนั้น มันก็จะสรุปอย่างมั่นใจ และให้คำแนะว่าควรทำอะไรต่อบ้าง (หลายระบบถูกออกแบบให้ proactive จึงมักให้คำแนะนำเสมอ แม้ว่าผู้ใช้ไม่ได้ถาม)

ปัญหาคือ…บางครั้งถ้าทำตามคำแนะนำที่มันให้ กลับรังแต่จะส่งผลเสีย

นอกจากนั้นในระบบที่มี privilege จริง ผลลัพธ์อาจไม่ใช่แค่คำแนะนำผิด แต่เป็นสิ่งที่ทำไปแล้วไม่สามารถแก้ไขอะไรได้

จะเห็นว่าในหลายๆ กรณีความเสียหายไม่ได้เกิดจากการที่ AI วิเคราะห์ข้อมูลผิด

แต่เกิดจากมันถูกหลอกให้ทำสิ่งที่ไม่ควรทำ แถมยังทำด้วยความมั่นใจเต็มร้อยเสียด้วย

นี่คือจุดที่คำว่า LLM tail risk เริ่มมีความหมาย และถ้าอยากเข้าใจว่ามันน่ากลัวตรงไหน

เราคิดว่าเริ่มเล่าแบบนี้ดีกว่าค่ะ…

ทั้งไฟแนนซ์และระบบ LLM ในการใช้งานจริงมีความไม่แน่นอน (stochastic) แต่ที่มาของความไม่แน่นอนและรูปแบบความเสี่ยงต่างกัน

⸻

🔸 ไฟแนนซ์และ LLM : การ random ต่างสไตล์

ในโลกการเงิน ไม่มีใครรู้ราคาพรุ่งนี้แน่นอน เพราะข้อมูลที่ไม่สมบูรณ์, ผู้เล่นแต่ละคนมีมุมมองต่อโลกไม่เหมือนกัน และเมื่อมีข่าวใหม่ทุกคนก็พร้อมจะเปลี่ยนมุมมองทันที

Random แบบไฟแนนซ์คือ “สภาพแวดล้อมของโลกจริง” ซึ่งมนุษย์ไม่สามารถปิดมันได้ …ทำได้แค่พยายามอยู่กับมันให้รอด

LLM ก็ใช้การ random เช่นกัน…คำถามเดียวกัน อาจได้คำตอบต่างกัน เช่น น้ำเสียงเปลี่ยน

รายละเอียดไม่เหมือนเดิม (หรือบางทีก็หลงเชื่อไปทำตาม attacker ในบางครั้ง)

นี่คือสิ่งที่แตกต่างอย่างมากจากการ coding แบบเดิมๆค่ะ

⸻

🔸programming และ LLM : ตรรกะที่ต่างจากเดิม

ในโลก programming แบบดั้งเดิม เราคุ้นกับตรรกะนี้:

input → logic → output

ถ้า input เหมือนเดิม output ก็ต้องเหมือนเดิม!

นี่คือโลกของ: if–else, rules, deterministic systems

ถ้ามันพัง แปลว่า code ผิด ไม่ใช่ “ดวงไม่ดี”

แต่ LLM ไม่ได้ทำงานแบบนั้นค่ะ

⸻

🔸LLM ไม่ได้ “ตัดสินใจ” แต่มัน “ประเมินความน่าจะเป็น”

ในระดับพื้นฐานที่สุด LLM ไม่ได้ถามว่า “คำตอบที่ถูกคืออะไร?”

แต่มันถามว่า “token ถัดไปน่าจะเป็นอะไร?”

พูดให้เห็นภาพคือ …ในหัวของโมเดล มันเห็น distribution ประมาณนี้ตลอดเวลา: คำหนึ่ง ~ 35%, อีกคำหนึ่ง ~ 25% และอีกหลายคำที่ยัง “พอใช้ได้”

สิ่งที่เราเห็นเป็นประโยคที่ลื่นไหลนั้นจริง ๆ แล้วใช้การสุ่มจาก distribution นี้ซ้ำแล้วซ้ำเล่า

นี่คือเหตุผลที่คำตอบเดียวกัน เขียนต่างกันได้ โดยคำตอบมักมีโครงสร้างคล้ายเดิม แต่ไม่เหมือนเดิมเป๊ะ และบางครั้งก็ล้ำเส้นไปแม้จะไม่มีใครตั้งใจ

⸻

🔸 แล้วทำไมบางครั้งมันดู deterministic มากล่ะ?

คำตอบคือ …เพราะเรา บังคับให้มันสุ่มน้อยลง โดยผ่านสิ่งที่เรียกว่า temperature, top-p, decoding strategy

ถ้า temperature = 0 แล้วโมเดลจะเลือกคำที่ probability สูงสุดเสมอ ซึ่งจะได้ผลลัพธ์ที่ ดูเหมือน deterministic เพราะ โมเดลอาจให้คำตอบเหมือนเดิมได้ในเงื่อนไขที่ “ทุกอย่างคงที่” แต่ว่าระบบ LLM ที่ใช้งานจริงมักไม่เคยคงที่ เพราะ context/retrieval/tools/updates ทำให้ผลลัพธ์ end-to-end ยังผันผวนได้เสมอ

แต่จุดสำคัญคือแม้ตอนนั้น โมเดลก็ยังคิดแบบ “ความน่าจะเป็น” อยู่ และเราแค่เลือกทางที่ conservative ที่สุด

นอกจากนั้น temperature =0 ก็ไม่ได้หมายความว่าจะปลอดภัยจาก attacker นะคะ เพราะมันเพียงแค่ทำให้ output เสถียรขึ้น

⸻

🔸 เมื่อความ random LLM ไม่ได้มาจากโมเดลอย่างเดียว

ในระบบ LLM ที่ใช้งานจริงนั้นความไม่แน่นอนมาจากหลายชั้น เช่น:

• context ที่เปลี่ยนไปตามประวัติการสนทนา

• retrieval ที่ดึงข้อมูลไม่เหมือนเดิมทุกครั้ง

• tool outputs จากระบบภายนอก

• model updates

• policy changes

• concurrency และ latency

ดังนั้นแม้ว่าเราจะใช้ prompt เดิม และตั้ง temperature = 0

end-to-end system ก็ยังไม่ deterministic แบบ code

เพราะว่าความไม่แน่นอนที่เกิดขึ้น มันมาจาก 2 แหล่งหลักคือ

• Model-level randomness (temperature/top-p/decoding) ➡️ hallucination, instruction-following failure, jailbreak, goal hijack

• System-level randomness (retrieval/tool outputs/history/model updates/concurrency) ➡️ retrieval poisoning, tool misuse, prompt injection via untrusted data, race conditions, partial failures

การลด temperature ช่วยได้เฉพาะ model-level แต่ tail risk ตัวจริงมักอยู่ที่ system-level + privilege + adversary

นี่คือจุดที่ LLM เริ่ม “คล้าย finance” ไม่ใช่เพราะมันเหมือนตลาด แต่เพราะมันเป็น probability-driven system

⸻

🔸 เรื่องเล่าที่เปลี่ยนวิธีคิดของทั้งวงการ: LTCM

มามองความเสี่ยง LLM สไตล์ไฟแนนซ์กันค่ะ

แน่นอนว่าความเสี่ยงของ LLM และไฟแนนซ์แตกต่างกัน

ไฟแนนซ์คือโลกที่ อยู่กับความ random มานานมาก แถมยังเคยพังเพราะมันมาแล้วหลายครั้ง จึงได้บทเรียนแบบเจ็บปวดว่าความเสี่ยงที่แท้จริง ไม่ได้อยู่ตรงกลาง

เพื่อให้เข้าใจว่าทำไม finance ถึงกลัว “หาง” …มารู้จักกองทุนหนึ่งชื่อ Long-Term Capital Management (LTCM) กันค่ะ

LTCM ก่อตั้งช่วงกลางทศวรรษ 1990 โดยทีมที่เรียกได้ว่า “โปรไฟล์เทพ” สุดๆค่ะ มีทั้งนักคณิตศาสตร์การเงินระดับโลก, อดีตผู้บริหารธนาคารใหญ่ และนักเศรษฐศาสตร์รางวัลโนเบล 2 คน!

โมเดลของพวกเขาซับซ้อน elegant และ “ถูกต้องตามทฤษฎี” มาก

โดยแนวคิดหลักคือ: ถ้าสินทรัพย์สองอย่างควรมีราคาสัมพันธ์กัน แต่วันนี้มันเบี่ยงออกจากกันเล็กน้อย เดี๋ยวมันจะกลับมาเอง

กลยุทธ์นี้ไม่หวือหวา ไม่ใช่การพนัน และสามารถเก็บกำไรเล็ก ๆ แต่สม่ำเสมอได้

ในช่วงแรก LTCM ทำเงินได้ดีมาก เรียกว่าดีจนธนาคารหลายแห่งยอมปล่อยกู้ให้ในปริมาณสูง

เพราะทุกอย่างดูปลอดภัย

⸻

🔸 ทำไม LTCM ดูปลอดภัยมาก?

เหตุผลหลักมี 3 ข้อ:

(1) โมเดล backtest ได้สวย เพราะใช้คณิตศาสตร์ขั้นสูง วิเคราะห์ความสัมพันธ์เชิงสถิติ และทดสอบกับข้อมูลย้อนหลังแล้ว “แทบไม่เคยพัง”

(2) ผลลัพธ์ในอดีตนิ่ง มีกำไรเล็ก ๆ แต่ต่อเนื่อง แทบไม่มีวันที่ขาดทุนหนัก ความผันผวนต่ำมาก

(3) ความเสี่ยงดู “กระจายแล้ว” เพราะลงทุนหลายตลาด หลายประเทศ หลายสินทรัพย์

ภาพรวมคือ: ระบบดูนิ่ง ความเสี่ยงดูต่ำ และทุกอย่าง “สมเหตุสมผล”

นี่คือสิ่งที่ทำให้ทุกคนลดการ์ดลง

🔸 แต่แล้ววันที่โลกไม่เดินตามสมมติฐานก็มาถึง…

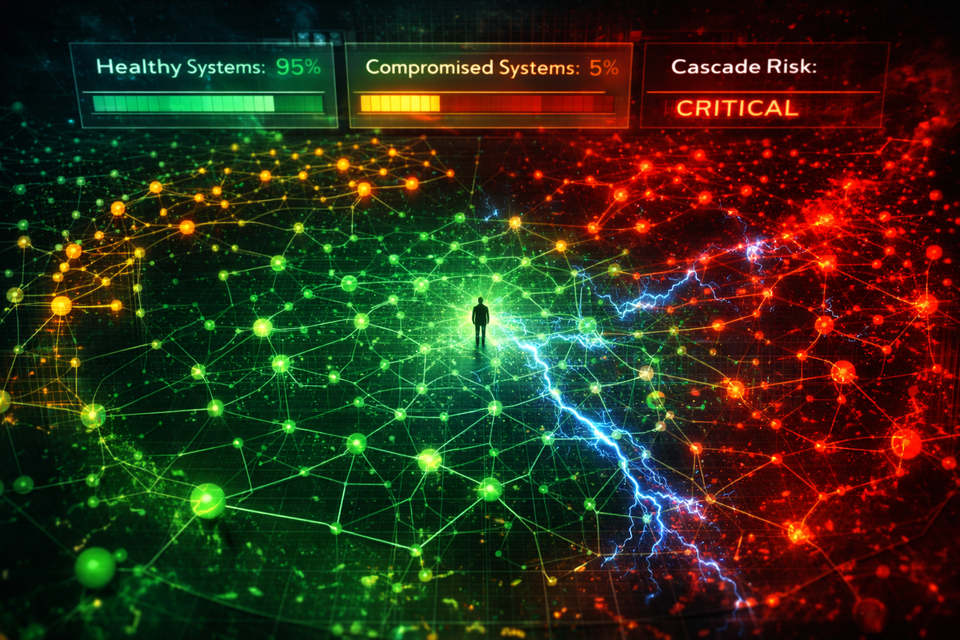

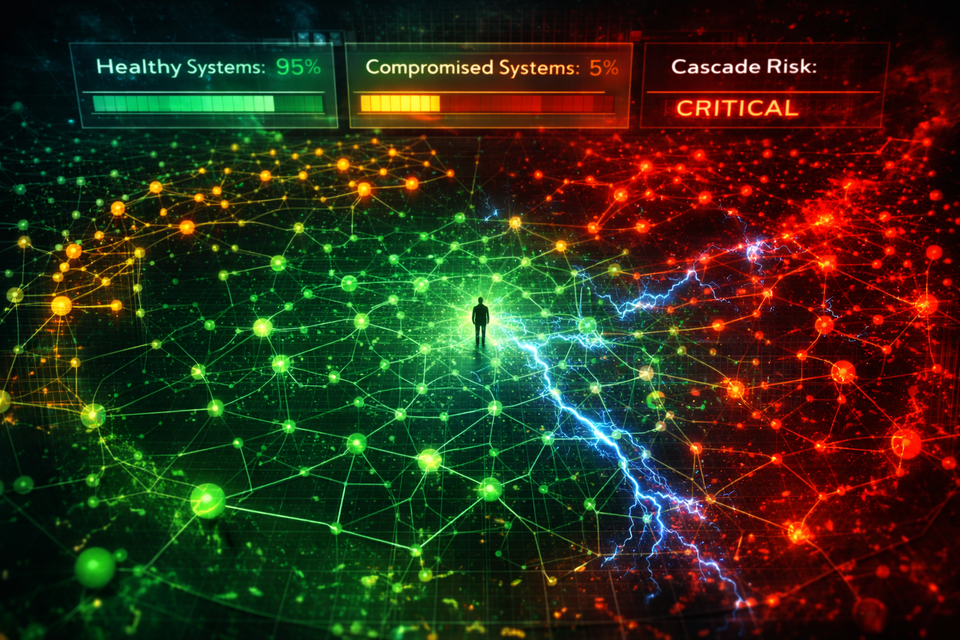

ในปี 1998 รัสเซียประกาศผิดนัดชำระหนี้

เหตุการณ์นี้ไม่อยู่ในข้อมูลย้อนหลัง ไม่อยู่ใน stress scenario แถมยังทำให้ตลาดทั่วโลก กลัวพร้อมกัน!

สิ่งที่เกิดขึ้นคือ นักลงทุนแห่หนีความเสี่ยง สินทรัพย์ที่คิดว่าไม่เกี่ยวกัน กลับร่วงพร้อมกัน

correlation ที่โมเดลเชื่อว่าเสถียร เรียกได้ว่าพังหมด

และเพราะ leverage สูง …เมื่อราคาไม่กลับเร็วพอ ก็ถูกบังคับลดพอร์ตในตลาดที่สภาพคล่องหายไป

สิ่งที่โมเดลคิดว่า “แทบไม่เกิด” กลับเกิดขึ้นจริง นอกจากนั้นยังเกิดพร้อมกันในหลายตลาดอีกด้วย

ภายในเวลาไม่นาน LTCM สูญเสียมูลค่าประมาณ 4.6 พันล้านดอลลาร์ ส่งผลให้ระบบการเงินเสี่ยงล้มเป็นโดมิโน ทำให้ธนาคารกลางสหรัฐต้องเข้ามาจัดการ

ในโลก LLM ‘leverage’ เทียบได้กับ privilege และ automation ➡️ พอหลุดทีเดียว ความเสียหายขยายแบบทวีคูณ

⸻

🔸 คำถามคือ…โมเดลของ LTCM ผิดไหม?

คำตอบคือ: โมเดล ‘ไม่ผิดในกรอบสมมติฐานของมัน’ แต่กรอบนั้นพังเมื่อโลกเปลี่ยน regime

เพราะว่ามันทำงานตามสมมติฐาน โดยใช้ข้อมูลย้อนหลังอย่างถูกต้อง และวัดความเสี่ยงใน distribution ที่มันรู้จัก

ปัญหาไม่ใช่ว่ามันไม่ฉลาดพอ แต่มันเพียงแค่มองไม่เห็นอนาคต

⸻

🔸บทเรียนที่ finance จำไม่ลืม: tail inevitability

จาก LTCM finance เรียนรู้บทเรียนที่โหดมากว่า เหตุการณ์ที่ดู “แทบไม่มีโอกาสเกิดขึ้นเลย”

ถ้ามีเวลามากพอมันจะเกิด

นี่เป็นคณิตศาสตร์ของเวลาและสเกล

ปาฏิหาริย์ที่มีโอกาสเพียง 1 ในล้าน มันจะเกิดขึ้นแน่นอนถ้าเราสุ่มหลายล้านหน

LLM ก็เป็นระบบสุ่มเช่นเดียวกันกับตลาดการเงิน แต่ว่า ความ random ของ LLM มาจากโมเดล + ระบบ ไม่ได้เกิดมาจากโลกธรรมชาติล้วน ๆ แถมโลกของ LLM มี adversary อีกด้วย

ที่สำคัญคือ distribution ของ failure ใน LLM ไม่ได้คงที่ เพราะ adversary จะเรียนรู้ว่าอะไรทำให้ระบบหลุด และจะผลักให้เราเจอหางบ่อยขึ้นเรื่อย ๆ

หลาย failure ของ LLM นั้น ไม่ได้เกิดบ่อย ไม่ได้อยู่ตรงกลางของ distribution ในการใช้งานทั่วไป แต่รุนแรงมากเมื่อมันเกิดขึ้น

นี่คือ pattern เดียวกับสิ่งที่ finance เคยพังมาแล้ว

และในโลก LLM adversary นั้น attacker ไม่ได้รอให้ 1 ในล้านโผล่มาเอง แต่พยายาม ‘ค้นหา’ ให้มันโผล่เร็วขึ้น และการวิธีการค้นหานั้นมักทำอย่าง systematic เสียด้วยค่ะ

สำหรับ attacker แล้ว ทุกๆครั้งที่การโจมตีไม่ประสบผลสำเร็จ เราจะได้ข้อมูลว่า ครั้งนี้เราใช้วิธีนี้ แต่ไม่สำเร็จ (ซึ่งถ้าลองแบบเดิมซ้ำก็อาจจะสำเร็จ) และถ้าโชคดีก็จะได้เงื่อนงำเพิ่มเติมว่า “เพราะอะไร” จึงไม่สำเร็จอีกด้วย

Attacker ไม่รอให้โมเดลพลาดเองนะคะ แต่วางกับดักทุกอย่างที่คิดได้เพื่อให้มันหลุดค่ะ

⸻

🔸สรุปโพสต์นี้

โพสต์ #1 นี้คืออารัมภบทที่เราอยากปูกรอบความคิดว่า ทั้ง finance และ LLM เป็น stochastic systems แต่ความเสี่ยงไม่ได้อยู่ที่ “ความสุ่มเฉลี่ย” … ความเสี่ยงอยู่ที่ส่วน “หาง”

ซึ่งไม่ถามว่า “จะเกิดไหม” แต่ถามว่า “เมื่อไร”

และในโลก LLM หางนั้นไม่ได้รอให้โผล่มาเอง แต่มักถูก adversary ผลักให้มาเร็วขึ้น และแรงขึ้น โดยเฉพาะเมื่อระบบมี privilege และ automation

คำถามสำคัญจึงไม่ใช่ว่า “เราจะทำให้ LLM ไม่พลาดเลยได้ไหม” แต่ว่าเป็น “เมื่อวันที่แย่มาถึงจริง ๆ เราจะยังยืนอยู่ได้หรือเปล่า?”

ในโลกการเงิน มนุษย์เคยกลัวคำถามนี้มาก่อน และได้สร้างเครื่องมือขึ้นมาเพื่อ บังคับตัวเองให้มองมันตรง ๆ

โพสต์ถัดไป เราจะมาดูกันว่า ความกลัวแบบนี้ ทำให้ finance คิดค้นเครื่องมืออย่าง VaR และ Expected Shortfall ขึ้นมาได้อย่างไร

ตอนที่ 2: VaR, Expected Shortfall, Stress Testing