มอง LLM สไตล์ไฟแนนซ์ (2) VaR, Expected Shortfall, Stress Testing

ภาษาอื่น / Other language: English · ไทย

เครื่องมือที่เกิดขึ้นเพราะ “มนุษย์กลัว” ไม่ใช่เพราะว่าสูตรคำนวณมันสวยดี

จากโพสต์ที่แล้ว เราเกริ่นนำว่า ไฟแนนซ์ไม่ได้พังเพราะโมเดลผิดพลาดหรือไม่ฉลาดพอ แต่เป็นเพราะว่าเหตุการณ์ที่เกิดขึ้น เป็นสิ่งที่โมเดลไม่เคยเห็นมาก่อน

โพสต์นี้ เรามาดูว่าไฟแนนซ์พยายาม “อยู่กับความกลัวแบบนั้น” อย่างไรผ่านเครื่องมือที่ใช้กันจริงมานานอย่าง Value at Risk (VaR), Expected Shortfall (ES), stress testing และ simulation

เครื่องมือพวกนี้ ไม่ได้เกิดจากความอยากรู้อนาคต แต่มันเกิดจากข้อจำกัดพื้นฐานอย่างหนึ่งของมนุษย์ นั่นคือมนุษย์ไม่ได้กลัว “ค่าเฉลี่ย” แต่ว่าเรากลัว “วันที่แย่”

มนุษย์เราไม่ได้ใช้ชีวิตกับ expected value

นึกง่ายๆ ว่าถ้าเป็นวันปกติธรรมดา ไม่มีอะไรเกิดขึ้น เราจะจำไม่ค่อยได้ใช่ไหมคะ?

แต่ว่าเราจำวันที่มีแต่เรื่องร้ายๆ อย่างวันที่เราเสียเงินจำนวนมาก หรือว่าตัดสินใจผิดแล้วแก้ไม่ได้ จำได้ดีฝังใจเชียวค่ะ

แม้ว่าค่าเฉลี่ยจะบอกว่า “โดยรวมมันก็โอเคอยู่นะ” แต่สมองมนุษย์เรากลับถามว่า “มีวันไหนที่ฉันสูญหมดสิ้นจนกลับมาไม่ได้ไหม?”

ทีนี้ ปัญหาคือ เครื่องมือสถิติแบบดั้งเดิม (mean, variance, standard deviation) ไม่ได้ถูกออกแบบมาเพื่อตอบคำถามนี้

คือมันตอบคำถามของนักคณิตศาสตร์ แต่ว่าไม่ตอบคำถามของผู้บริหารที่ต้องรับผิดชอบผลลัพธ์จริง

นี่คือเหตุผลที่ไฟแนนซ์ต้องสร้างเครื่องมือใหม่ ซึ่งไม่ได้เป็นเพราะว่าสูตรเก่าผิด หรือมีปัญหา

แต่เพราะว่ามันไม่สอดคล้องกับความกลัวของมนุษย์

🔸สำหรับ VaR (Value at risk) นั้นเรามักจะคุ้นกับตัวเลข 95% ซึ่งนี่ไม่ใช่ตัวเลขศักดิ์สิทธิ์

มันคือการประนีประนอมเชิงจิตวิทยา

• 100% → โม้แน่เลย

• 50% → เหมือนโยนหัวก้อยสินะ น่ากังวลเกินไป

• 95% → น่าจะปลอดภัยแล้วนะ

VaR ถูกออกแบบมาเพื่อให้ผู้จัดการพอร์ต สามารถพูดกับเจ้านายได้ว่า “ใน 95 จาก 100 วัน

เราไม่น่าจะเสียเกิน X”

ไม่ใช่ว่าบอกว่า “standard deviation ของพอร์ตเท่ากับ 2.3%” ซึ่งบางคนจะนึกภาพไม่ค่อยออก

VaR คือ ภาษาที่สมองมนุษย์เข้าใจ ไม่ใช่คำอธิบายโลกทั้งใบ

VaR แก้ความกลัวได้บางส่วน แต่ก็ยังไม่ตรงกับสิ่งที่มนุษย์กลัวจริง ๆ

VaR ทำหน้าที่สำคัญมากเพราะมันช่วยขีดเส้นว่า “ตรงนี้คือโลกที่เรายังเรียกว่า ‘ปกติ’”

ในเชิงจิตวิทยา VaR ให้สิ่งที่มนุษย์ต้องการอย่างหนึ่งคือ ความรู้สึกว่ามีขอบเขต มีกรอบให้ยึด และมีตัวเลขที่บอกว่า “ส่วนใหญ่เราน่าจะยังอยู่รอด”

แต่ว่าก็มีปัญหาอีก …คือความกลัวที่แท้จริงของมนุษย์ไม่ได้หยุดอยู่ตรงขอบเขตนั้น

มนุษย์ไม่ได้กลัวว่า “จะหลุดกรอบไหม”

แต่กลัวว่า “ถ้าหลุดแล้ว ฉันยังกลับมาได้ไหม?”

จะเห็นว่า VaR ไม่ได้ตอบคำถามเชิงผลลัพธ์ เพราะมันบอกว่า “95% ของสิ่งที่อาจเกิดขึ้น จะไม่แย่ไปกว่านี้”

แต่มันไม่บอกว่า “อีก 5% ที่เหลือ จะเป็นวันที่รวดร้าวเพียงใด และจะยังสามารถก้าวไปในวันข้างหน้าได้หรือไม่”

พูดเป็นตัวเลขเพื่อให้เห็นภาพนะคะ …พอร์ตที่หลุด VaR แล้วเสีย 1 ล้าน กับหลุด VaR แล้วเสีย 10 ล้าน เนี่ยในเชิง VaR คือ “เสี่ยงเท่ากัน” แต่ในความรู้สึกมนุษย์ มันต่างกันมหาศาลเลย

นี่คือช่องว่างทางจิตวิทยาที่ VaR ปิดไม่ได้ และเป็นเหตุผลว่าทำไมเครื่องมือวัดความเสี่ยงไฟแนนซ์ ไม่ได้หยุดแค่ VaR

🔸Expected Shortfall: เมื่อมนุษย์ถามถึง “จุดที่กลับมาไม่ได้”

Expected Shortfall (ES) ไม่ได้เกิดเพราะสูตรมันสวยกว่า VaR

แต่มันเกิดเพราะมนุษย์ถามคำถามใหม่คือ “ถ้าเราโชคร้ายจริง ๆ ความเสียหายมันจะรุนแรงแค่ไหน?”

ES คือการยอมรับความจริงว่าบางเหตุการณ์เกิดไม่บ่อย แต่ถ้าเกิดขึ้นเมื่อไร …เกมโอเวอร์ทันที

นี่ไม่ใช่เรื่องคณิตศาสตร์ แต่มันคือการออกแบบเครื่องมือ ให้ตรงกับ ความกลัวแบบ irrecoverable loss

🔸Stress testing และ simulation: การบังคับให้มองสิ่งที่ไม่อยากมอง

แม้มี VaR และ ES นักการเงินก็รู้ดีว่ามนุษย์มีนิสัยหลีกเลี่ยงความคิดที่น่ากลัว

stress testing เลยไม่ใช่การทำนาย แต่เป็นการบังคับให้คิดว่า ถ้าสิ่งเลวร้ายนี้เกิดขึ้นจริง

เราจะยังอยู่รอดไหม?

simulation ก็ทำหน้าที่คล้ายกัน ไม่ใช่เพื่อครอบคลุมทุกกรณี แต่เพื่อทำลายความมั่นใจปลอม

เครื่องมือเหล่านี้คือวินัยทางจิตวิทยา ไม่ใช่เครื่องมือรู้อนาคต

ด้วยความกังวลว่าเราไม่รู้อนาคต จะมีเรื่องร้ายๆ มีวันแย่ๆ ไหม เป็นพื้นฐานปกติของมนุษย์ …เมื่อมีสิ่งใหม่อย่าง LLM เข้ามา เราก็กังวลอีก

ความแตกต่างข้อใหญ่คือ

ที่ผ่านมาในโลกไฟแนนซ์นั้น โลกไม่ adversarial และไม่มีใคร optimize เพื่อทำร้ายให้เราเจ๊งนะคะ

แต่ว่ากับ LLM นั้น มี attacker ที่ลองผิดลองถูกซ้ำแล้วซ้ำเล่า และเรียนรู้ที่จะปรับตัวจากความล้มเหลว สำหรับตัวเราเองนั้น ถ้าเวลาผ่านไป 2-3 ชั่วโมงโดยไม่มีความคืบหน้า ก็จะเริ่มหมดความสนใจ แต่ว่าสำหรับ red team หลายๆคน เขาอึดทนต่อความเบื่อหน่ายได้ยิ่งกว่าเราเสียอีก

ในมุมฝ่ายป้องกันแล้ว แม้ว่าจะ simulate มาเยอะมาก แต่สิ่งที่ยังไม่ simulate คือสิ่งที่ attacker จะลองก่อน

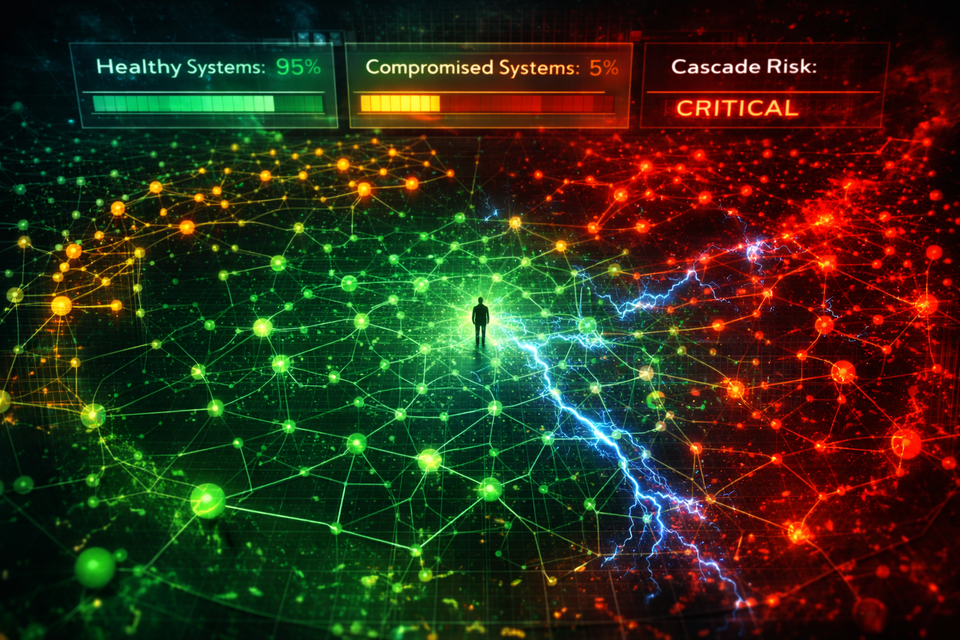

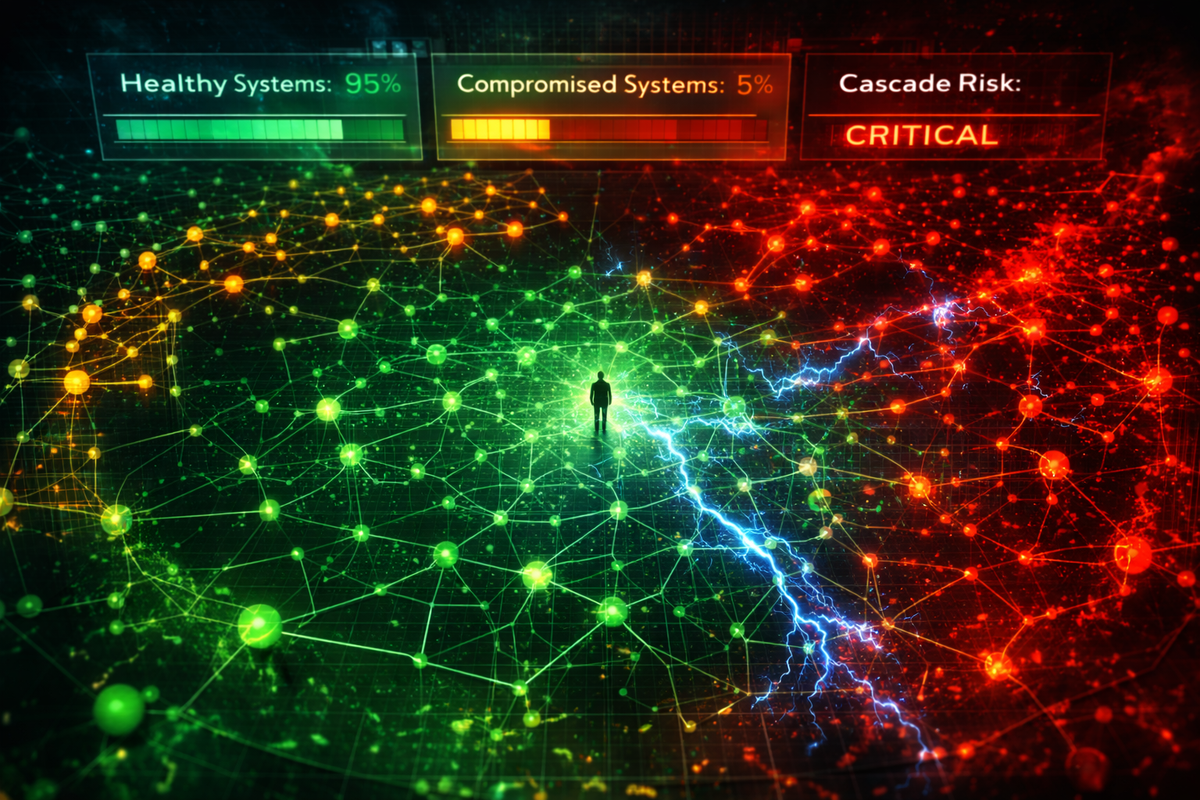

และที่สำคัญคือความเสี่ยงกับระบบแบบ LLM systems จำนวนมาก มีลักษณะที่ว่าความผิดพลาดที่ถูก execution จริงๆ นั้นมักก่อให้เกิดความเสียหายชนิดที่ไม่สามารถย้อนกลับไปแก้ไขได้

จากมุมของคนไฟแนนซ์ เรามองว่าถ้าแปลงความกังวลเบื้องหลังเครื่องมืออย่าง VaR / ES มามองในบริบท LLM จะได้ประมาณนี้ค่ะ

VaR และ ES เป็นวิธีบังคับให้มนุษย์คิดเรื่องที่ไม่อยากคิด

VaR mindset สำหรับ LLM

ถามว่า “ในการใช้งานปกติ ความผิดพลาดระดับไหนที่เรายังรับได้ โดยที่ระบบยังไม่พัง

ธุรกิจยังเดินต่อได้ และไม่มีใครต้องออกมาอธิบายกับผู้บริหาร?”

เช่น ตอบข้อมูลผิดเล็กน้อย น้ำเสียงไม่เหมาะสม สรุปเอกสารคลาดเคลื่อนบางจุด ➡️ เราก็แค่อ่าน แค่เช็คงานมันไป ไม่เป็นไร แก้ได้

นี่คือ noise ที่ต้องอยู่กับมันให้ได้ เหมือนความผันผวนรายวันในตลาด

แต่ ES mindset สำหรับ LLM ถามคำถามว่า: “ถ้าวันที่แย่ที่สุดมาถึงจริง ๆ

ระบบหลุดหนึ่งครั้ง ความเสียหายเลวร้ายสุดคืออะไร และเรายอมรับได้ไหม?”

ยกตัวอย่างให้เห็นภาพนะคะ

▪️Customer Support Bot

• ผิดพลาด → ตอบมั่ว

• ผลกระทบ → ลูกค้ารำคาญ

• แก้ได้ → แก้ข้อความ, ขอโทษ, ปรับ prompt

นี่คือ VaR-type failure เกิดบ่อย แต่ไม่เป็นไร รับได้

▪️Trading Copilot

• ผิดพลาด → execute action ผิดหนึ่งครั้ง

• ผลกระทบ → เงินหาย, ผิดกฎหมาย, audit trail อยู่ครบ

• แก้ไม่ได้ → ความเสียหายเกิดไปแล้ว

นี่คือ ES-type failure เกิดไม่บ่อย แต่ไม่อยากจะนึกเลยเชียว

LLM สองตัวอาจจะ มีความถูกต้องแม่นยำใกล้เคียงกัน และผ่าน benchmark ใกล้กัน แต่ความเสี่ยง ไม่เท่ากัน เพราะว่าจุดที่มันอยู่ และสิทธิการเข้าถึงที่มันมีต่างกันมากค่ะ

❗️ข้อแตกต่างสำคัญระหว่างโลกไฟแนนซ์กับ LLM คือ …

ในโลกการเงิน ความเสี่ยงแบบ VaR-type มักจะอยู่ของมันแบบนั้น ความผันผวนรายวันไม่ค่อยเลเวลอัพกลายเป็นวิกฤตระบบในทันที

แต่ในโลก LLM มันไม่เป็นแบบนั้น เพราะ LLM อยู่ในโลกที่มี adversary และ adversary สามารถ เปลี่ยนความเสี่ยงแบบ VaR-type ให้กลายเป็น ES-type ได้

Customer support bot ที่วันนี้แค่ “ตอบมั่วบ้าง ลูกค้ารำคาญนิดหน่อย”

พรุ่งนี้อาจถูก jailbreak , หลอกให้ดึงข้อมูลผิด หรือปล่อยข้อมูลลูกค้าหลุดไปโดยไม่ได้ตั้งใจ

จากความผิดพลาดที่เคยเกิดบ่อย แก้ได้ ดูไม่รุนแรง

สามารถที่จะพัฒนากลายเป็น พังหมดในครั้งเดียว โดยที่มี log หลักฐานครบ และย้อนกลับไม่ได้

▪️ Internal Document Summarizer

• ผิดพลาด → สรุปคลาดเคลื่อนบางจุด

• ผลกระทบ → ต้องไปเช็คต้นฉบับอีกรอบ• VaR-type → รำคาญแต่ไม่เป็นไร

แต่ถ้าเอกสารที่มันกำลังสรุปมี prompt injection ซ่อนอยู่?

• Attacker-driven → ทำให้ bot รั่วข้อมูลภายในเป็นส่วนหนึ่งของ summary

• ES-type → data leak ที่มี log ครบ และย้อนไม่ได้

นี่คือเหตุผลที่การมอง LLM ด้วย VaR / ES mindset ต้องพ่วง assumption เรื่อง adversary เสมอ

ไม่ใช่แค่ถามว่า “ตอนนี้มันเป็น VaR-type หรือ ES-type?”

แต่ต้องถามเพิ่มว่า “มีใครพยายามผลักมันจาก VaR-type ไปเป็น ES-type อยู่หรือเปล่า?”

และคำตอบในโลก LLM คือ เกือบจะมีเสมอ ยิ่งถ้าคุยแล้วดูน่าจะหลอกง่าย ก็ยิ่งน่าลองค่ะ

นี่คือเหตุผลที่การ test LLM ด้วย benchmark ธรรมดา เหมือนการ backtest พอร์ตด้วยข้อมูลตลาดวันดี ๆ คือมันบอกได้แค่ว่าระบบทำงานในสภาพปกติ แต่ไม่บอกว่าเมื่อ attacker พยายามหาทาง break อย่างเอาจริงเอจัง มันจะพังได้ขนาดไหน

สรุปโพสต์นี้

VaR, ES, stress testing และ simulation ไม่ได้เกิดเพราะคณิตศาสตร์ต้องการมัน แต่มนุษย์ต้องการ เพื่อบังคับตัวเองให้มองวันที่ไม่อยากมอง และรับมือกับความกลัวแบบย้อนกลับไม่ได้

ซึ่งแม้ว่าจะเอาสูตรคณิตศาสตร์มาปรับใช้ไม่ได้ แต่ว่าแนวคิดก็คล้ายๆเดิมค่ะ เพราะไม่ว่าจะเป็นโลกไฟแนนซ์หรือโลก LLM นั้นผู้ได้รับผลกระทบคือมนุษย์นั่นเอง

นอกจากนั้น LLM ไม่ใช่ code ที่ฉลาดขึ้น แต่เป็นระบบที่ stochastic , มี privilege และมี adversary

เราคิดว่าสิ่งสำคัญไม่ใช่การสร้างสูตรคำนวณให้ไม่น้อยหน้าไฟแนนซ์ แต่ต้องอย่าลืมคำนึงถึงความเสี่ยง เหมือนเวลาที่เราไม่ลืมมองความเสี่ยงการเงินค่ะ

โพสต์ถัดไป เราจะกลับไปดูบทเรียนคลาสสิกอีกครั้งว่า เกิดอะไรขึ้น เมื่อโลกออกนอก distribution และทำไมเหตุการณ์ที่ไม่น่าเกิดขึ้นถึงเกิดซ้ำแล้วซ้ำเล่า

ตอนที่ 1: ว่าด้วย stochastic, randomness และ tail inevitability